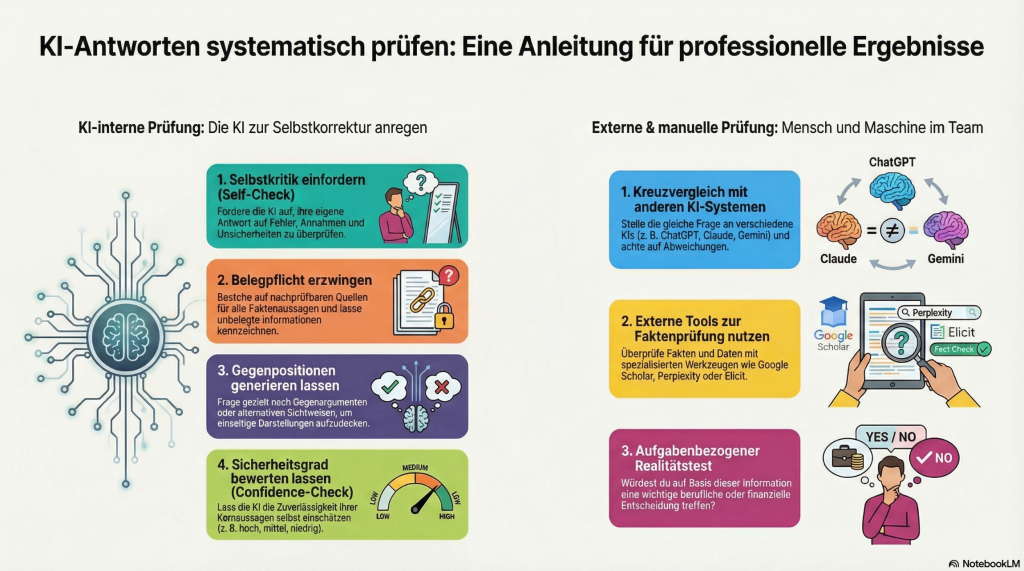

KI Antworten systematisch prüfen

KI-Antworten systematisch prüfen

Eine praxisorientierte Anleitung für professionelle Ergebnisse

Künstliche Intelligenz hat sich in Bildung, Pflege, Verwaltung und Wissenschaft zu einem leistungsfähigen Unterstützungsinstrument entwickelt. Gleichzeitig gilt: KI-Systeme erzeugen keine Wahrheit, sondern wahrscheinlich klingende Antworten auf Basis statistischer Muster. Für professionelles Arbeiten ist daher eine systematische Überprüfung von KI-Ergebnissen unverzichtbar. Die folgende Anleitung beschreibt ein zweistufiges Vorgehen, das KI-interne Prüfmechanismen mit externer und menschlicher Kontrolle kombiniert.

1. KI-interne Prüfung: Die KI zur Selbstkorrektur anregen

Ein erster, niedrigschwelliger Schritt besteht darin, die KI selbst zur kritischen Reflexion ihrer Antwort zu veranlassen. Richtig eingesetzt, kann dies offensichtliche Fehler, blinde Flecken oder Übervereinfachungen sichtbar machen.

1.1 Selbstkritik einfordern (Self-Check)

Die KI wird gezielt aufgefordert, ihre eigene Antwort zu überprüfen: Welche Annahmen wurden getroffen? Wo bestehen Unsicherheiten? Welche Aussagen könnten fehlerhaft oder kontextabhängig sein?

Dieser Schritt fördert Transparenz und verhindert, dass KI-Antworten als „fertige Lösungen“ missverstanden werden.

1.2 Belegpflicht erzwingen

Professionelle Nutzung erfordert nachvollziehbare Quellen. Die KI sollte explizit aufgefordert werden, alle Faktbehauptungen zu belegen oder kenntlich zu machen, wenn keine belastbaren Quellen vorliegen.

Gerade im Gesundheits-, Pflege- und Bildungsbereich ist dieser Schritt zentral, um Fehlinformationen oder veraltete Inhalte zu erkennen.

1.3 Gegenpositionen generieren lassen

KI-Antworten sind oft linear und konsensorientiert. Durch gezielte Nachfrage nach Gegenargumenten, alternativen Sichtweisen oder kritischen Einwänden lassen sich einseitige Darstellungen aufdecken.

Dies unterstützt insbesondere ethische, pädagogische oder wissenschaftliche Fragestellungen, bei denen Mehrperspektivität essenziell ist.

1.4 Sicherheitsgrad bewerten lassen (Confidence-Check)

Die KI kann gebeten werden, die Zuverlässigkeit ihrer Kernaussagen selbst einzuschätzen, etwa auf einer Skala von „niedrig“ bis „hoch“.

Auch wenn diese Einschätzung keine objektive Garantie darstellt, sensibilisiert sie für Unsicherheiten und verhindert eine unkritische Übernahme der Ergebnisse.

2. Externe und manuelle Prüfung: Mensch und Maschine im Team

KI-interne Prüfungen sind hilfreich, ersetzen jedoch keine externe Validierung. Für professionelle Kontexte ist eine zweite Prüfebene zwingend erforderlich.

2.1 Kreuzvergleich mit anderen KI-Systemen

Die gleiche Fragestellung wird parallel an unterschiedliche KI-Modelle gestellt. Weichen die Antworten deutlich voneinander ab, ist dies ein klares Signal für Unsicherheiten oder Interpretationsspielräume.

Übereinstimmungen hingegen erhöhen – nicht beweisen, aber erhöhen – die Plausibilität der Aussagen.

2.2 Externe Tools zur Faktenprüfung nutzen

Für faktenbasierte Inhalte sollten spezialisierte Recherche- und Evidenztools eingesetzt werden, etwa wissenschaftliche Suchmaschinen oder KI-gestützte Literaturfinder.

Dieser Schritt ist besonders relevant bei rechtlichen, medizinischen oder wissenschaftlichen Aussagen, da hier aktuelle und geprüfte Quellen entscheidend sind.

2.3 Aufgabenbezogener Realitätstest

Eine einfache, aber wirkungsvolle Prüffrage lautet:

„Würde ich auf Basis dieser Information eine wichtige berufliche, pflegerische oder finanzielle Entscheidung treffen?“

Wenn die Antwort „nein“ lautet, ist die KI-Ausgabe als Denk- oder Diskussionsimpuls zu werten – nicht als Entscheidungsgrundlage.

Fazit: Kritische KI-Kompetenz als Schlüsselqualifikation

Der professionelle Umgang mit KI erfordert weniger technisches Spezialwissen als vielmehr kritische Urteilskompetenz. KI-Antworten sind keine Autoritäten, sondern Vorschläge, die geprüft, eingeordnet und verantwortet werden müssen.

Gerade in der Pflege, Bildung und Wissenschaft gilt:

KI kann entlasten, strukturieren und inspirieren – die Verantwortung bleibt beim Menschen. Wer KI-Ergebnisse systematisch überprüft, nutzt ihr Potenzial, ohne fachliche Qualität, ethische Standards oder professionelle Verantwortung zu gefährden.